Nakon nešto dužeg perioda u kojem se nismo bavili recenzijama ni prenošenjem iskustava korisnika, danas ćemo se pozabaviti relativno mladom distribucijom Linuxa koja je u vrlo kratkom vremenu zauzela mjesto među prvih deset najpopularnijih distribucija prema evidenciji Distrowatcha.

Punim imenom elementary OS 0.3 Freya, distribucija je objavljena prije dva mjeseca nakon dugog iščekivanja kada će se pojaviti nasljednica Lune (prethodne verzije, 0.2). Nakon objave 11. travnja i narednih par burnih dana (burnih ne zbog izlaska Freye, već zbog načina preuzimanja ISO slike sa službenih stranica projekta), sve se nekako stišalo, izostale su recenzije, savjeti, rasprave za i protiv… Zapravo, jedino mjesto na kojem gotovo svakodnevno možete pročitati ili naći nešto novo vezano za elementary OS i Freyu je zajednica okupljena na elementary OS G+.

Pustimo sad razloge zašto je tome tako i krenimo na priču o elementary OS timu i zadnjoj stabilnoj inačici njihovog OS-a, Freyi.

![elementary OS 0.3 Freya - Live]()

elementary OS 0.3 Freya – Live

Malo povijesti nikad ne škodi

Iako Jupiter (kralj bogova u rimskoj mitologiji, bog neba, oluja, munja i grmljavine) i nije bio “zasebna distribucija” u pravom smislu riječi, već skup tema, ikona i alata dodanih na tadašnju verziju Ubuntua 10.10, ipak je donio nešto drugačije što me za ono kratko vrijeme prije kraja njegovog životnog puta dovoljno zainteresiralo da nastavim pratiti kako se razvija elementary OS.

Nakon Jupitera je došla Luna (rimska božica mjeseca), temeljena na LTS izdanju Ubuntua 12.04. Luna je donijela korisnicima jedno novo, drugačije, i pozitivno iskustvo jasno ukazujući da minimalizam i vizualna privlačnost ne moraju nužno biti svrha sami sebi. Naprotiv, pokazalo se da se u takvom desktop okruženju može i sasvim ugodno svakodnevno raditi (op.a. Luna mi je još uvijek primarna distribucija), bez obzira jeste li Lunu ostavili onakvom kakvu su je tvorci zamislili, ili ste ipak malo (ili malo više) zaronili ispod površine i dodatno je prilagodili sebi.

Već kod Lune se mogao naslutiti i jedan drugi smjer u kojem idu razvijatelji elementary OS distribucije, a to je zatvorenost. Je li to posljedica samostalnog razvoja određenog broja aplikacija ili bitnih dijelova operativnog sustava (Pantheon ili Gala npr.) ili ne, činjenica je da tolika zatvorenost nije po volji mnogim korisnicima.

![Luna - izvor: Wikipedia]()

Luna – izvor: Wikipedia

Budući da Luna ima podršku do travnja 2017. godine, možda i nije bilo potrebe ići na novu s obzirom na dobru prihvaćenost Lune i skromne resurse kojima je elementary ekipa raspolagala. Unatoč tome, dolaskom Ubuntua 14.04 elementary ekipa je odlučila krenuti s razvojem nove verzije svoje distribucije. Istovremeno su napustili dotadašnje imenovanje distribucija po bogovima iz rimske mitologije i za novu verziju OS-a odabrali ime Isis (Isis=Izida; egipatska boginja, zaštitnica žena, prirode, prijateljstva, robova i još koječega).

![Freya - izvor: Wikipedia]()

Freya – izvor: Wikipedia

Međutim, zbog globalnih događaja koji nemaju veze s Linuxom i ovo ime biva napušteno (kao i egipatska mitologija), a za novi projekt odabiru ime Freya (nordijska božica ljubavi, ljepote i plodnosti) koja nakon dvije godine razvoja, 11. travnja 2015. biva dovršena te objavljena kao stabilno izdanje najnovije verzije elementary OS-a.

Gotovo istovremeno s objavom Freye započinje rad na sljedećoj verziji elementary OS-a pod nazivom Loki (nordijski bog spletki; općenito se za njega veže sve zlo i loše, a po nekim vjerovanjima Loki i nije bio bog već Odinova tamna strana osobnosti). Loki će se temeljiti na LTS verziji Ubuntua 16.04, no kako su zasad informacije o novostima šture, vrijeme je da se napokon posvetimo elementary OS 0.3 Freyi. Promišljanja o tome je li za novu verziju izabrano sretno ime ili ne ostavljamo za neka buduća vremena.

Pogled prvi

Da je Luna imala mlađu sestru, zasigurno bi se zvala Freya. Mlađa, ljepša, poletnija…i razmaženija, zahtjevnija i pomalo umišljena.

Freyu sam ozbiljnije počeo koristiti od bete2 (kao i Lunu) no za razliku od Lune bete 2, Freya je bila prepuna bugova. Ono što je bez problema radilo jučer, danas bi se raspalo bez vidljivog razloga. Kako se približavao travanj 2015. za koji se šaputalo da bi mogao biti mjesec objave finalne verzije, tako su bugovi i povremene nestabilnosti bili sve rjeđi i rjeđi, te sam odmah po službenoj objavi Freyu pohitao instalirati na laptop (Lenovo U350).

Ostadoh ugodno iznenađen brzinom instalacije, prepoznavanjem hardvera (Broadcom WiFi kartica koja nigdje nije radila bez naknadne instalacije vlasničkog drivera na Freyi je proradila out-of-the-box) te općenitom brzinom rada na ipak jako slabom hardveru. S druge strane, ostao sam i razočaran smrzavanjem OS-a, starim bugovima i nekim dojmom da još nije trebala biti objavljena.

![Broadcom BCM4312 - out-of-the-box]()

Broadcom BCM4312 – out-of-the-box

Iako sam imao namjeru koristiti Freyu kao primarnu distribuciju nekih dva-tri tjedna i potom napisati recenziju, zbog navedenih problema te nekih privatnih obveza odustao sam od toga i odgodio recenziju za neke bolje dane, dajući time Freyi još malo vremena da se uozbilji i ugleda na stariju sestru.

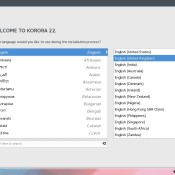

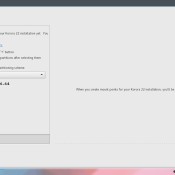

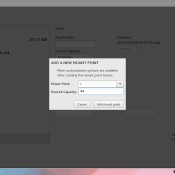

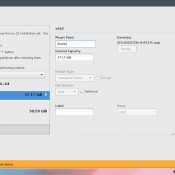

Instalacija, dogradnja i uređivanje – čin prvi

O instalaciji se zapravo i nema što puno pisati jer je već viđena mnogo puta. Kao napomenu bih ipak istaknuo moguće probleme prilikom particioniranja diska, jer sam se i sam susreo s njima. Uzrok problema mi nije jasan i ne mogu ih pripisati Freyi, Gpartedu ili nečem trećem, no nikako nisu ugodni za korisnika.

Naime, Freyu sam za potrebe recenzije instalirao ukupno osam puta na četiri različite konfiguracije kako bih, nakon ranije navedenih problema s instalacijom odmah po objavi, dobio bolji uvid u ponašanje OS-a na različitom hardveru (dva laptopa i dva desktopa – popis testnog hardvera pogledajte na kraju teksta). Tri puta mi se prilikom promjene veličine particije dogodilo da se OS privremeno smrzne, nakon čega bi Gparted obrisao sve particije i ostavio mi prazan SSD.

Kao što možete zamisliti, ovo iskustvo je jako neugodno ako nemate backup, ali i ako imate backup a radili ste dualboot s Windowsima (bolje da vam ne govorim koliko vremena i živaca uzme ponovna instalacija W7 i sve sile njegovih nadogradnji). Napominjem da mi se to dogodilo na dva različita SSD-a, dok s klasičnim HDD-om nije bilo problema, pa možda zec leži negdje u tom grmu.

![Instalacija u par slika]()

![Disk spreman za particioniranje]()

![Particionirani disk - root/home/swap]()

![Odabir zemlje]()

![Odabir tipkovnice]()

![Unos imena korisnika i računala te passworda]()

![Instalacija na disk započela u 10.42 ..]()

![.. a završila u 10.46 sati - brzo, brzo :)]()

Ako Freyu instalirate na prazan disk ili ako ste ionako odlučili sve obrisati, onda s instalacijom nema nikakvih problema. Sama instalacija je brza; toliko brza da nemate vremena ni skuhati si kavu, jer sam proces instalacije od trenutka kad ste upisali svoje korisničke podatke i kliknuli na “Instaliraj” do obavijesti da je instalacija završila u prosjeku traje 4 do 5 minuta.

Preporuka za početnike

Recimo da vas Freya ipak zanima, no spadate u grupu korisnika koji ne znaju ili ne žele znati puno o Linuxu, i ne žele se baviti terminalom već im je draži način održavanja OS-a kroz GUI (grafičko sučelje).

Nema problema. Iako će doljenavedena instalacija programa koje mnogi svakodnevno koriste biti moguća kroz GUI putem “Centra softvera” jednostavnim upisivanjem imena programa u tražilicu i jednim klikom na “Instaliraj”, ovdje ću ipak opisati kako se to puno jednostavnije i brže radi putem terminala. Ako zbog ničega drugog, onda da onima koji odluče probati na lak način razbijem strah od terminala.

Za početak, odmah nakon instalacije Freye (ili bilo koje druge Linux distribucije) je potrebno napraviti nadogradnju (update) sustava. Nakon prvog restarta taj se proces odvija automatski, te ćete nakon par minuta u docku (Plank) vidjeti ikonu s dostupnim nadogradnjama. Lijevi klik na nju, ovjerite je vašom lozinkom (passwordom), i sustav će obaviti ostalo sam, a na kraju će zatražiti ponovni restart.

Nakon toga – ili usporedno s time – upoznajte se sa svojim novim operativnim sustavom. Podesite ključne stavke za svakodnevno korištenje, kao što su dodavanje ili uklanjanje ikona na dock (Plank), uređivanje pozadinske slike, docka i kutova zaslona, pregled i podešavanje postavki privatnosti i sigurnosti, podešavanje postavki energije i slično. Kako sve to izgleda možete pogledati u videu ispod.

Iako Freya dolazi s više-manje svim potrebnim aplikacijama za svakodnevno osnovno korištenje (koji su usput i vizualno prilagođeni Freyi), neke aplikacije ćete možda poželjeti zamijeniti, dok je druge potrebno dodati. Kao što sam već ranije napisao, to je moguće izvesti u “Centru softvera”, no brži i jednostavniji način je pomoću terminala. Izbor ostavljam eventualnim budućim korisnicima Freye. Oni koji se ipak odluče za terminal ispod priloženog videa mogu pronaći popis naredbi za dodavanje osnovnih aplikacija.

Ako se odlučite za terminal, pokrenite ga i upisujte jednu po jednu naredbu (prvi put će zatražiti vašu lozinku (password)). Nadalje, ako želite kopirati naredbe umjesto da ih sami upisujete, terminal će vas prvi put upozoriti da kopiranje naredbi nije sigurno. Ovo se može onemogućiti, ali to ne spada u dio za početnike, pa neka ostane za neke naredne upute i tweakove. Da biste nastavili s radom, samo potvrdite da vam je rizik kopiranja naredbi jasan.

- sudo apt-get install ubuntu-restricted-extras

- sudo apt-get install firefox

- sudo apt-get install thunderbird

- sudo apt-get install libreoffice

- sudo apt-get install libreoffice-style-sifr (ovo nije dio libre-officea već set monokromatskih ikona za ljepši izgled)

- sudo apt-get install vlc

- sudo apt-get install rar

- sudo apt-get install pinta

- sudo apt-get install gimp

I za kraj nije loše ponovno upisati naredbu:

- sudo apt-get update && sudo apt-get upgrade

nakon čega ćete imati funkcionalan i oku ugodan OS. Ako je vjerovati službenim informacijama, i onih nekoliko uočenih, pomalo iritantnih bugova će uskoro nestati. Ovdje završava moj pogled; čitamo se dalje kod zaključka, a sada pozornicu prepuštam kolegi s foruma.

Pogled drugi

Moj proces traženja distribucije koju ću svakodnevno koristiti trajao je dugo; jako dugo. Proveo sam više od godinu dana isprobavajući razne distribucije, i uvijek bih pronašao nešto što mi ne odgovara. GNOME mi je bio prevelik. KDE me nije oduševljavao. Zajedničko svima bilo je pregrijavanje laptopa uzrokovano korištenjem open source upravljačkog programa za moju AMD Radeon grafičku koju vlasnički upravljački program više ne podržava.

A onda sam jednog dana isprobao Lunu. Bila je dovoljno nezahtjevna za resursima, pa su i problemi s pregrijavanjem bili znatno manji nego s bilo kojom drugom dotad isprobanom distribucijom (a bilo ih je desetak). I da, oduševio sam se njenim minimalizmom. Jednostavan panel na vrhu, dock i odličan pokretač aplikacija bili su dobitna kombinacija za mene.

Zatim je došla Freya. Instalirao sam je par dana nakon što je izašla beta1. Od tog dana do danas sam reinstalirao sustav samo jednom (otprilike mjesec dana nakon što se pojavila beta2). Freya nije revolucionarno izmijenjena u odnosu na prethodnu verziju, kao što je to bio slučaj s Lunom. Radilo se više na malim stvarima koje poboljšavaju korisničko iskustvo. Animacije su popravljene, sve defaultne aplikacije su dobile nove funkcije ili su zamijenjene aplikacijama koje više odgovaraju elementary OS-u.

O sustavu

Sustav je dizajniran tako da ga mogu koristiti i oni koji imaju vrlo malo znanja o računalima općenito. Mišljenja sam da je mnogo lakše naučiti koristiti Freyu nego Windowse. Sve aplikacije su jednostavne za korištenje. Pokretač aplikacija (Slingshot Launcher) je sada brži i bolje dizajniran, a dobio je i neke zgodne funkcije poput računanja jednostavnih matematičkih operacija bez pokretanja kalkulatora.

![I to je Freya by r3bl]()

I to je Freya by r3bl

Naravno, ova jednostavnost može zasmetati naprednim korisnicima, i oni će vrlo vjerojatno zamijeniti većinu, ako ne i sve defaultne aplikacije. Sam proces obavljanja zadataka je prilično jednostavan. Operativni sustav je u pozadini i ne smeta vam pri pokretanju aplikacija i radu s njima. Gotovo ga i ne primjećujete. S elementary OS-om nemate osjećaj da se “borite” protiv računala dok obavljate svakodnevne aktivnosti, kao što se to može činiti u radu s drugim operativnim sustavima. Moram priznati da se ni sa čime sličnim nisam dosad susreo. U međuvremenu se nešto izmijenilo i kod open source grafičkog drivera koji koristim, pa moj Asus sada radi na nižoj temperaturi nego ikada prije (specifikacije možete pronaći na kraju teksta).

Nažalost, Freya još uvijek nije potpuno stabilna, i smatram greškom to što je trenutna verzija proglašena stabilnom umjesto “RC” (Release Candidate) verzije. Stabilna verzija se dugo iščekivala, elementary projekt je dobio mnogo više pažnje i samim time su razvijatelji bili izloženi većem pritisku tijekom izrade Freye. Problemi se pojavljuju s vremena na vrijeme, što vam može predstavljati problem ako ne znate engleski. Ako ga pak znate, tu je odlična elementary zajednica na Google+ kojoj se možete obratiti za pomoć.

Ipak moram priznati da je moje ukupno iskustvo korištenja Freye pozitivno. Gledao sam tu djevojčicu kako raste od svoje beta1 verzije do trenutne, a i sam sam sudjelovao u projektu koliko sam mogao. Preveo sam (gotovo) cijeli operativni sustav na bosanski jezik, svoj doprinos sam dao i trenutnom izgledu web stranice projekta, i uvijek sam bio tu da pružim svoje mišljenje ili samo promoviram projekt. Po mom mišljenju, Freya se nalazi pred krajem svojih tinejdžerskih godina i počinje sazrijevati.

O projektu

elementary projekt je dosta specifičan. Provukao se u top 10 distribucija relativno brzo (uzimajući u obzir da je star tek nekoliko godina). Razvijatelji su uspjeli kreirati nešto novo i zanimljivo čak i onima koji prije nisu koristili Linux. Više od dvije trećine preuzimanja Freye vrši se s Windowsa ili OS X-a. Naravno, ovo nam ne govori koliko je elementary projekt pridonio povećanju Linux zajednice, ali je svakako dao svoj doprinos i ostavio trag.

Budući da je elementary projekt postao vrlo popularan, a samim time se povećao i broj očiju koje ga prate, razvijatelji su odlučili da elementary OS izraste iz projekta na kojem rade u svoje slobodno vrijeme u projekt za koji su plaćeni. Zahvaljujući svojim vjernim korisnicima i njihovim mjesečnim donacijama, dva glavna razvijatelja su uspjela kreirati neprofitnu organizaciju putem koje ostvaruju profit za projekt elementary OS-a. Kako se donacije budu povećavale, tako će se povećati i broj stalnih članova elementary razvojnog tima.

Dakako, ova odluka nije prošla sasvim bezbolno, a sam proces je bio okružen kontroverzom, no sada kada je sve riješeno, elementary je s pravom postao najveći indie operativni sustav na svijetu. Ako vam se elementary projekt svidi, savjetujem da mi se pridružite i donirate nešto novca ovom projektu. Čak i ja kao student mogu izdvojiti 10 dolara (oko 70 kuna) mjesečno da pomognem svom najdražem open source projektu.

Instalacija, dogradnja i uređivanje – čin drugi

Nakon instalacije operativnog sustava možda ga poželite još malo urediti u skladu sa svojim potrebama. Za to vam preporučujem elementary-tweaks, dconf-editor i elementary-add pakete.

elementary-tweaks je zbog svoje jednostavnosti u korištenju najpopularniji alat za uređivanje elementary OS-a. Međutim, njegovo korištenje nema bezrezervnu podršku vlasnika elementary OS projekta jer lako može narušiti stabilnost sustava. Ovdje svakako uzmite u obzir i da je autor elementary-tweaksa prije nekoliko tjedana objavio da zbog privatnih obveza odustaje od njegovog daljnjeg razvoja. Od tada je projekt bez podrške sve dok netko drugi ne odluči preuzeti razvoj. Ukoliko se ipak odlučite isprobati i koristiti ga, instalaciju možete obaviti upisivanjem sljedećih naredbi u terminal:

- sudo apt-add-repository ppa:mpstark/elementary-tweaks-daily

- sudo apt-get update

- sudo apt-get install elementary-tweaks

dconf-editor je pak alat koji može izvršiti sve što i elementary-tweaks, no uz to je sposoban i za još mnogo drugih stvari. Međutim, korištenje ovog alata ne preporuča se manje iskusnim korisnicima ili onima koji površno čitaju/gledaju što rade, jer sadrži neke postavke koje se ne bi smjele mijenjati.

![ScreenFetsh - Freya by r3bl]()

ScreenFetsh – Freya by r3bl

S druge strane, dconf-editor je bolji izbor za uređivanje jer je njegovo korištenje u smislu prilagođavanja sustava teže, pa se podrazumijeva da će ga koristiti oni koji znaju u što se upuštaju i koji će znati samostalno popraviti eventualne pogreške i probleme. Ako još niste odustali od dconf-editora, instalacija je jednostavna unošenjem naredbe:

- sudo apt-get install dconf-editor

elementary-add je najjednostavniji paket koji možete instalirati da biste malo uredili svoj operativni sustav. Paket sadrži ikone za popularnije Linux aplikacije koje svojim dizajnom više odgovaraju dizajnu elementary OS-a. Zadana elementary tema za ikone sadrži samo ikone za aplikacije koje su instalirane po defaultu, pa je ovaj paket nadopunjava.

Već na samom početku razvijanja Freye razvijatelji su zamolili zajednicu da se aktivno uključi u kreiranje aplikacija dizajniranih posebno za elementary OS. Zajednica je poziv prihvatila, pa nam je trenutno dostupno desetak odličnih aplikacija koje su razvili programera nepovezani s elementary projektom. Da biste ih isprobali, posjetite blog Made for elementary te elementary apps projekt. Ovi resursi stvoreni su s ciljem da na jednom mjestu obuhvate sve projekte dizajnirane za elementary OS.

Made for elementary sadrži samo stabilnije aplikacije, dok su u elementary apps listi uključeni i oni projekti koji su tek na početku svog razvoja.

Oni koje zanima više o tweakanju Freye mogu posjetiti i naš forum te temu namijenjenu upravo tome.

Zaključak prvi

I kome je zapravo Freya namijenjena? Sudeći po zatvorenosti, trebala bi biti namijenjena početnicima u svijetu “kućnih korisnika” Linuxa koji će distribuciju prihvatiti takvu kakva jest i u tom je obliku svakodnevno koristiti. S druge strane, postavlja se pitanje kako će se isti ti korisnici nositi s povremenim problemima te hoće u potpunosti biti zadovoljni dobivenim.

S činjenicom da je Freya vizualno privlačna (iako je i to individualno) vjerojatno će se složiti većina. Da je brza i da je na prosječno jakom (pa i slabijem od toga) hardveru ugodno obavljati svakodnevne poslove “kućnog korisnika” također nije sporno, no ipak je ne mogu preporučiti kao primarnu distribuciju za svakoga.

Zapravo, moje mišljenje o Freyi je podijeljeno. S jedne strane je zatvorenost sustava dobra stvar za neupućene korisnike ili korisnike kojima treba samo jednostavna i lijepa GNU/Linux distribucija, jer jamči da će OS raditi i biti uvijek onakav kakvog su ga tvorci zamislili bez potrebe za uplitanjem (ili znanjem) korisnika.

S druge pak strane, pojedini bugovi koji se pojavljuju i najčešće nestaju nakon restarta mogu iritirati ili otjerati korisnike, što je šteta. Isto tako, pojedine funkcije (ili nedostatak nekih) također mogu odvratiti neke korisnike od Freye, jer oni nemaju znanja ili volje zagrebati ispod površine i probleme ili podešavanja odrađivati dconf-editorom ili terminalom.

Od iritantnih bugova moram izdvojiti bezrazložno nestajanje sata i datuma iz gornjeg panela koji se privremeno rješavao ponovnim pokretanjem sustava. Trajno sam ga riješio tek uređivanjem “custom” postavki prikaza datuma i vremena (navedeno nisam mogao popraviti ni dconfom). Spomenuo bih i bug koji se manifestira kod pokušaja premještanja mapa ili datoteka na principu povlačenja (drag-and-drop). Događalo se da nakon ispuštanja premještene ikone dobijem vidljiv gornji rub ikone i dupliranu strelicu kursora (desna je lažna), a bug je ili nestao sam od sebe nakon nekog neodređenog vremena, ili bih morao posegnuti za restartom.

![Dio hardvera na kojem je odrađeno testiranje.]()

Dio hardvera na kojem je odrađeno testiranje.

Zaključak drugi

Freyu preporučujem korisnicima koji žele isprobati nešto lagano i minimalistično te onima koji se žele fokusirati na rad bez da im operativni sustav stoji na putu. Međutim, ipak je ne bih preporučio ljudima koji se ne snalaze baš dobro s engleskim jezikom, kao ni onima koji očekuju maksimalnu stabilnost sustava. Ako tražite nešto što će vas uvesti u Linux svijet, a spremni ste malo tweakati i hakirati svoj sustav da bi ga unaprijedili ili prilagodili svojim potrebama, onda samo naprijed – Freya je za vas.

Popis hardvera korištenog za recenziju:

desktop:

HP dx7400 (Intel c2q 6600, 8 GB DDR2, VGA nVidia GTX 650, OCZ SSD i WD Black HDD)

no-name PC (AMD X2 5000 BE, 2 GB DDR2, VGA nVidia GT 7600, WD Black HDD)

laptop:

HP ProBook 4530s (Intel i3-2310M, 8GB DDR3, HD 3000, Intel SSD i Seagate HDD)

Lenovo U350 (Intel U2300, 4GB DDR3, VGA Intel X4500M, OCZ SSD i WD Blue HDD)

ASUS X54HR (Intel i3 2350M, 4 GB DDR3 RAM, VGA AMD Radeon HD 7470M, HDD)

Autori: Aleksandar Todorović & Dario B.

)

)

).

).